Kleinvieh macht aber immer noch den meisten Mist.

Sagt der der 173 Spiele in seiner Steam Bibliothek hat ![]()

Kleinvieh macht aber immer noch den meisten Mist.

Sagt der der 173 Spiele in seiner Steam Bibliothek hat ![]()

Sagt der der 173 Spiele in seiner Steam Bibliothek hat

Ist doch wenig. Schau mal bei Spiritogre vorbei, der hat 944 Spiele, das ist dann schon mehr Kleinvieh, oder eher Großvieh ![]()

Ist doch wenig. Schau mal bei Spiritogre vorbei, der hat 944 Spiele, das ist dann schon mehr Kleinvieh, oder eher Großvieh

Wobei ich mir bei der Zählweise nicht im klaren bin? Scheint werden einige DLCs nicht gezählt und andere als eigenständiges Spiel aber generell viele Spiele werden auch gar nicht gezählt. Ich kann mir vorstellen, dass z.B. F2P Games nicht mitgezählt werden. Theoretisch sollte ich jedenfalls einiges mehr an Spielen und DLCs haben.

Großes UpdateVeröffentlicht

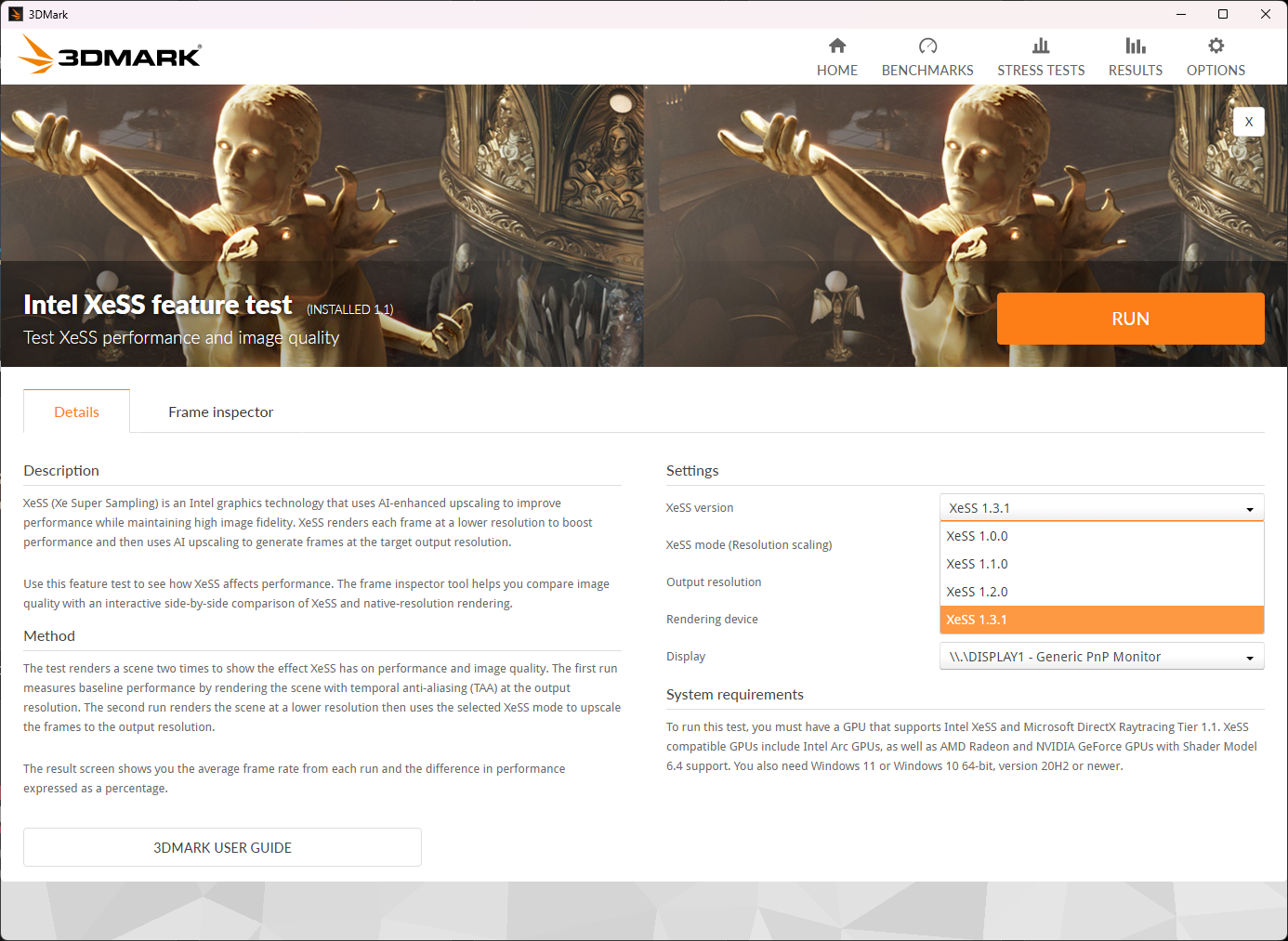

Testen Sie die neueste Version von Intel XeSS in 3DMark

Die Ansprüche der Gamer an ein flüssiges Gaming-Erlebnis sind im Laufe der Zeit immer größer geworden, egal ob sie einen Wettbewerbsvorteil suchen oder eine immersive, detailreiche Welt, in der sie sich verlieren können. Neue Upscaling-Technologien helfen Gamern, jedes mögliche Bild aus ihren PCs herauszuholen, von High-End-Desktops bis hin zu leichten Handhelds.

Mit der Einführung des 3DMark Intel XeSS-Funktionstests im Oktober 2022 war 3DMark eine der ersten Software, die die Vorteile des XeSS AI-Upscalings demonstrierte. Neben vielen Funktionstests für andere Upscaling- und Grafik-API-Technologien trägt der XeSS-Funktionstest dazu bei, dass 3DMark einer der besten Orte für Gamer ist, um zu testen, was die neuesten Gaming-Technologien leisten können.

Heute freuen wir uns, die Unterstützung für Intels neueste Version von XeSS bekannt zu geben. XeSS 1.3 soll bemerkenswerte Verbesserungen bei Leistung und Bildqualität liefern.

Der Intel XeSS-Funktionstest und das XeSS 1.3.1-Update wurden mit Input von Intel entwickelt, um eine Best-Practice-Implementierung von XeSS zu gewährleisten.

Mit der Veröffentlichung dieses Updates können Sie den XeSS-Funktionstest und den XeSS-Funktionstest-Frame-Inspector mit XeSS 1.0, 1.1, 1.2 und 1.3.1 ausführen.

Quelle: Intel XeSS 1.3 beschleunigt in die nächste Generation der KI-Upscaling

- Intel-Gaming-Zugriffsblog

XeSS 1.3 brachte neue Qualitätseinstellungen für Gamer, wobei die Auflösungsskalierung für jeden Modus angepasst wurde, um neue Verbesserungen der Bildqualität widerzuspiegeln. Mit dem Tool XeSS Feature Test Frame Inspector können Sie einzelne Frames exportieren, um sie zwischen verschiedenen Qualitätsmodi und XeSS-Versionen zu vergleichen.

Über Intel Xess

XeSS (Xe Super Sampling) ist eine Grafiktechnologie von Intel, die KI-gestütztes Upscaling nutzt, um die Leistung zu verbessern und gleichzeitig eine hohe Bildtreue beizubehalten. XeSS rendert jedes Bild in einer niedrigeren Auflösung, um die Leistung zu steigern, und verwendet dann KI-Upscaling, um Bilder in der Zielausgabeauflösung zu generieren.

Weitere Informationen zu XeSS finden Sie auf der Website von Intel .

Jetzt verfügbar

Das Update Intel XeSS Featuretest 1.3.1 ist ein kostenloses Update für den 3DMark Intel XeSS Featuretest.

Um den Intel XeSS Featuretest auszuführen, benötigen Sie eine GPU, die Intel XeSS und Microsoft DirectX Raytracing Tier 1.1 unterstützt. Zu den XeSS-kompatiblen GPUs gehören Intel Arc GPUs sowie AMD Radeon- und NVIDIA GeForce GPUs mit Shader Model 6.4-Unterstützung. Sie benötigen außerdem Windows 11 oder Windows 10 64-Bit, Version 20H2 oder neuer.

Was ist neu in 3DMark v2.29.8294

Dieses Update unterstützt die Aufnahme von XeSS 1.1, 1.2 und 1.3.1 in den Intel XeSS-Funktionstest. Andere Benchmark-Ergebnisse sind davon nicht betroffen.

Neu

Unterstützung für XeSS 1.1, 1.2 und 1.3.1 zum Intel XeSS-Funktionstest hinzugefügt.

Schätzungen der Bildrate des Spiels wurden zur Ergebnisseite von Steel Nomad hinzugefügt.

Aktualisiert

Dem Intel XeSS-Funktionstest wurde Unterstützung für neue und geänderte XeSS-Qualitätsmodi hinzugefügt.

Im Intel XeSS-Funktionstest wurde die Standardversion von XeSS auf 1.3.1 und die Standardqualitätseinstellung von XeSS von „Ultra-Qualität“ auf „Ausgewogen“ geändert.

Behoben

Ein Problem wurde behoben, bei dem einige Tests des unbegrenzten Modus in der Benutzeroberfläche fehlten.

Sieht doch gut aus.

Nicht dass ich diese Art Grafikleistung innerhalb der nächsten paar Jahre überhaupt im Rechner haben werde...

... innerhalb der nächsten paar Jahre ...

Prinzipiell würde ich da zustimmen, aber so in 2-3 Jahren könnte da etwas bei mir durchaus passieren

Prinzipiell würde ich da zustimmen, aber so in 2-3 Jahren könnte da etwas bei mir durchaus passieren

Bei mir wahrscheinlich auch allerdings eben fernab solcher Leistungsklassen. Ich glaube nicht, dass z.B. eine GF 6070 oder 7070 schon an eine 5090 herankommen wird.

Bei mir wahrscheinlich auch allerdings eben fernab solcher Leistungsklassen. Ich glaube nicht, dass z.B. eine GF 6070 oder 7070 schon an eine 5090 herankommen wird.

Bis auf eine Ausnahme nach oben bin ich eh eher der 80er Vertreter, aber ich habe auch die 70er im Auge, die 60er gehen mal gar nicht.

Auch wenn das durchaus ebenfalls zutreffen würde, habe ich dabei nicht die Musik im Auge. ![]()

Bis auf eine Ausnahme nach oben bin ich eh eher der 80er Vertreter, aber ich habe auch die 70er im Auge, die 60er gehen mal gar nicht.

Auch wenn das durchaus ebenfalls zutreffen würde, habe ich dabei nicht die Musik im Auge.

Ja, ich möchte aber eigentlich auch in Zukunft unter 700 Euro bleiben und da bleiben dann nur die 70er. Ich meine, für meine letzte habe ich 430 Euro gezahlt und das war quasi die "teuerste Grafikkarte aller Zeiten" für mich. Wobei ich allerdings auch noch nie eine Karte so ewig lang im Dienst hatte.

Also keine großer Unterschied ob man 4 oder 5 verwendet gut zu wissen.

Interessant finde ich aber den Unterschied beim Benchmark von 26,89Gb´s / PCIe4 zu 119Gb´s / PCIe5 im 3DMark ![]()

Wäre schön wenn er dazu noch mal ein Vid macht,bin echt gespannt was 3DMark noch antwortet ![]()